AI Computers en Workstations: De Hardware Gids

AI Computers en Workstations: De Hardware Gids

AI is momenteel het meest besproken onderwerp in de IT-wereld. De ontwikkeling gaat razendsnel en met de komst van MCP Servers krijgt AI een enorme boost. Tools zoals Claude en Cursor helpen bij het ontwikkelen van software, en de toepassingen lijken eindeloos. Wij krijgen daarom veel vragen over de benodigde hardware - reden voor deze uitgebreide post. We hebben zelf een Hugging Face Server gebouwd om te experimenteren en delen hier onze bevindingen.

Onze AI-Workstation Configuraties

Onze AI-werkstations zijn uitgerust met krachtige CPU's, meerdere GPU's en geoptimaliseerd voor modelinferentie en training met NVIDIA GPU-versnelling. Deze systemen zijn ideaal voor het werken met populaire frameworks zoals PyTorch, Hugging Face, LlamaIndex en LangChain.

Voor generatieve AI hebben we speciale werkstations gebouwd voor software zoals Stable Diffusion, aangedreven door NVIDIA GeForce- en RTX-grafische kaarten. Deze systemen zijn ook zeer geschikt voor kleinere taalmodellen. Daarnaast bieden we configuraties die specifiek afgestemd zijn op generatieve AI, LLM en machine learning-ontwikkeling, evenals servers voor het hosten of trainen van grote taalmodellen.

Welke CPU is het meest geschikt voor LLMs?

Voor het uitvoeren van grote taalmodellen raden we twee CPU-platforms aan:

- Intel Xeon W: Bewezen prestaties in server-omgevingen

- AMD Threadripper PRO: Uitstekende prijs-prestatieverhouding

Beide bieden een hoog aantal cores, uitstekende geheugenprestaties en -capaciteit, plus veel PCIe-lanes. De 32-core versies van beide platforms krijgen onze voorkeur vanwege hun gebalanceerde prestaties.

Heeft meer CPU-kernen invloed op de snelheid?

Het aantal CPU-kernen heeft beperkte invloed op LLM-prestaties - er is minimaal één kern per GPU nodig. Echter, wanneer uw workflow meer omvat dan alleen het draaien van modellen, wordt de CPU cruciaal.

CPU-intensieve taken omvatten:

- Gegevensverzameling en voorbewerking

- Datapijplijnen en parsing

- Het creëren van embeddings

- Vectoropslag en -beheer

Deze taken kunnen op de CPU worden uitgevoerd om de GPU vrij te houden voor inferentie.

Intel vs AMD voor LLMs

Het maakt meestal weinig uit welk merk u kiest, zolang het platform maar van hoge kwaliteit en serverklasse is.

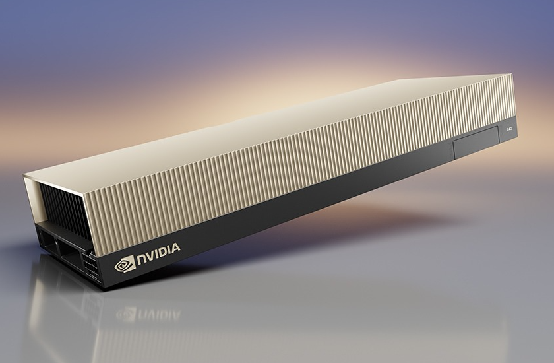

GPU: Het Hart van AI-Computing

GPU's hebben LLM-toepassingen mogelijk gemaakt door hun buitengewone prestaties voor dit soort rekenproblemen. De GPU is het belangrijkste onderdeel voor AI-toepassingen, met name GPU's met veel VRAM.

Welke GPU is het beste?

Voor LLM-servers raden we "Professional" of "Compute" GPU's aan vanwege:

- Grotere hoeveelheden VRAM

- Betere geschiktheid voor serverchassis en koeling

Aanbevolen modellen:

- NVIDIA RTX 6000 Pro en ADA, L40S, H100

- AMD MI Instinct GPU's

VRAM-vereisten: De Beperkende Factor

Bij LLMs is de totale beschikbare VRAM vaak de beperkende factor. Hier zijn enkele voorbeelden:

- 70B parameter modellen (zoals Llama3-70B): ~200 GB VRAM nodig in originele precisie

- Praktische opstelling: 4x RTX 6000 Ada of L40S GPU's voor goede prestaties in multi-user omgevingen

Het is mogelijk om met kleinere GPU's te werken, maar dit beperkt de grootte van de LLMs die u kunt draaien.

Voordelen van Meerdere GPU's

LLM-servers en frameworks maken uitstekend gebruik van meerdere GPU's. Een Linux-server met 4 tot 8 GPU's wordt beschouwd als "standaard" grootte voor professioneel gebruik.

Aanbevolen Starter Configuratie

Voor wie wil beginnen met AI-development:

- CPU: AMD Ryzen 9 9900X

- RAM: 64GB (bij voorkeur 128GB)

- GPU: RTX 5090

Let op: De RTX 5090 heeft grote fysieke afmetingen, wat uitbreiding kan beperken. Voor toekomstige schaalbaarheid zijn professionele kaarten een betere keuze, ondanks het hogere prijskaartje.

Conclusie

De keuze van AI-hardware hangt af van uw specifieke gebruik en budget. Begin met een solide basis en plan voor toekomstige uitbreiding. VRAM is vaak de beperkende factor, dus investeer hier verstandig in.

Heeft u vragen over de beste configuratie voor uw situatie? Neem contact met ons op voor persoonlijk advies.